OneService

共同供應契約

客戶服務

tsti YT

tsti Blog

投資人專區

新聞活動消息

AI, Cloud, ESG系列線上研討會Part II, 歡迎報名參加!

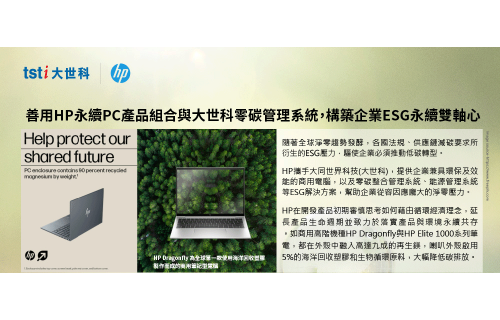

專注於AI、Cloud和 ESG 解決方案

[EDM] DELL PowerProtect Cyber Recovery 避風港計劃

網路與勒索軟體攻擊是當今資料型企業的最大敵人- 保護企業從保護資料開始

2023 CSEA 卓越客戶服務大獎 最佳客服數位智能系統供應企業

2023 CSEA 卓越客戶服務大獎獲獎名單公布囉! #最佳客服數位智能系統供應企業 大同世界科技股份有限公司

![大世科-[EDM] DELL PowerProtect Cyber Recovery 避風港計劃 大世科-[EDM] DELL PowerProtect Cyber Recovery 避風港計劃](/upload/4a9e5618-493a-466f-8a0c-4c0c07623735.jpg)

![大世科-[EDM] 如何才能充滿信心地擴展您的數據治理計劃? 大世科-[EDM] 如何才能充滿信心地擴展您的數據治理計劃?](/upload/ca5b4b58-9879-4389-a4ab-75a794dfe2e2.jpg)

![大世科-[EDM] 大世科助力凱基銀行 建置HPE GreenLake方案 創造銀行客戶最佳體驗 大世科-[EDM] 大世科助力凱基銀行 建置HPE GreenLake方案 創造銀行客戶最佳體驗](/upload/337d63f8-cbf3-43b7-904a-1f571723a24b.jpg)